›Medien bestimmen unsere Lage.‹

Meiner Meinung nach sind technische Medien nicht fügsame und neutrale Vermittler, vielmehr sind sie selbstkonfigurierend, ihre Bedingungen bestimmen die Art und Weise, wie menschliche Affekte und Bedeutungen in ihnen erzeugt und kanalisiert werden.

An dem Universalmedium Computer, das alle vorhergehenden Medien simuliert, sind meiner Meinung nach zwei Aspekte wesenhaft:

Die PROZESSTHEORIEN fassen den zeitliche Moment von Computern. Computersysteme zeigen ihre Wirkung erst im zeitlichen Vollzug, ausgeschaltet sind sie nur tote Materie. Diese sie charakterisierende Prozessualität weist eigene Zeitweisen auf und realsiert Wahrnehmungs- und Handlungsweisen jenseites des Menschenmöglichen. Dieser eigenständige nicht-humane Bereich ist wiederum an menschliche Wahrnehmungen und Handlungen rückgekoppelt, sie werden von diesem beeinflusst.

Der MEDIENMATERIALISMUS benennt die Einsicht, dass Computer, als materialisierte Praktik und Wissen, autonome Akteure darstellen. Sie werden nicht als Erweiterungen des Menschen angesehen, sondern bilden in ihren historischen Erscheinungsformen ein maschinelles Phylum aus, in dem sich Technik und Mathematik/Logik wechselseitig beeinflusst.

Friedrich Kittler

Meiner Meinung nach sind technische Medien nicht fügsame und neutrale Vermittler, vielmehr sind sie selbstkonfigurierend, ihre Bedingungen bestimmen die Art und Weise, wie menschliche Affekte und Bedeutungen in ihnen erzeugt und kanalisiert werden.

An dem Universalmedium Computer, das alle vorhergehenden Medien simuliert, sind meiner Meinung nach zwei Aspekte wesenhaft:

Die PROZESSTHEORIEN fassen den zeitliche Moment von Computern. Computersysteme zeigen ihre Wirkung erst im zeitlichen Vollzug, ausgeschaltet sind sie nur tote Materie. Diese sie charakterisierende Prozessualität weist eigene Zeitweisen auf und realsiert Wahrnehmungs- und Handlungsweisen jenseites des Menschenmöglichen. Dieser eigenständige nicht-humane Bereich ist wiederum an menschliche Wahrnehmungen und Handlungen rückgekoppelt, sie werden von diesem beeinflusst.

Der MEDIENMATERIALISMUS benennt die Einsicht, dass Computer, als materialisierte Praktik und Wissen, autonome Akteure darstellen. Sie werden nicht als Erweiterungen des Menschen angesehen, sondern bilden in ihren historischen Erscheinungsformen ein maschinelles Phylum aus, in dem sich Technik und Mathematik/Logik wechselseitig beeinflusst.

PROZESSTHEORIEN

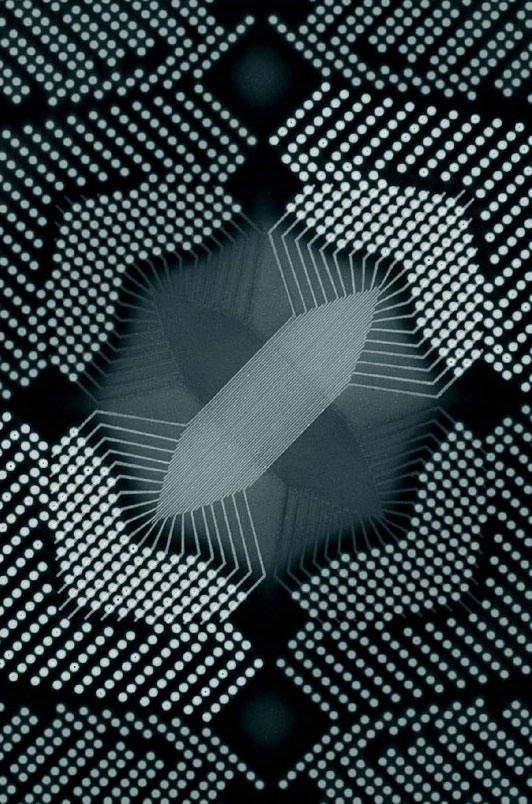

Originalshader (Quelle)

Prozessphilosophie – Im alltäglichen Erleben wird Zeit als ein linearer Fluß wahrgenommen, Ereignisse reihen sich sukzessive aneinander.

Diese Zeitwahrnehmung wird von Computersystemen radikal in Frage gestellt. Iterationen, Rekursionen und Schleifen sind Kontrollstrukturen in Programmroutinen, die einen bedingten und verzweigten Ablauf von Software erlauben.

Sie sind durch Differenzen und Wiederholungen geprägt und aktualisieren eine zyklische Zeitauffassung. Inwieweit diese dem menschlichen Zeitempfinden fremden Zeitlichkeiten in Computern vom Menschen nachvollzogen werden können, ist Gegenstand dieses Forschungsbereichs. An der Zeitform der digitalen Maschinen sind vor allem drei Momente modellbildend: Die Zeit ist diskret, die Latenzen zwischen den einzelnen Zeitmomenten sind extrem kurz und die Zeitmomente sind rekursiv aufeinander verwiesen. Diese Zeitform hat ihren Ursprung in der kybernetischen Modellbildung. Damit ist der Regelkreis angesprochen, der ein Steuersystem in seinem Operationsbereich hält, wie z.B. ein Thermostat die gewünschte Temperatur steuert. Dieses Denken findet seine historischen Vorläufer in der Prozessphilosophie von Whitehead und Hegel. An Hegels dialektischem Denken wird der Moment der Feedbackschleife ersichtlich, dass diese im Abgleich von Ist- und Sollwert einen Widerspruch auflöst. Der kritische Aspekt am Widerspruch ist, dass zwei antagonistische Positionen zu einer Revision auffordern, die nicht formal-logisch behoben werden kann, sondern erst in einem nächsten reflexiven zeitlichen Schritt, durch eine andere Position ersetzt wird. Whiteheads Zeitmodell ist ähnlich rekursiv, operiert aber auf einer ontologisch anderen Ebene. Whitehead entwickelte ein Prozessdenken, das die Prozesse atomisiert, in mikroskopisch kleine Ereignisse zerlegt, die der Mirkozeitlichkeit der computerbasierten System sehr nahe kommt. Auf einer Vielzahl an zeitlichen als auch räumlichen Skalen laufen dabei rekursiv verschachtelte Entwicklungen ab.

Diese Zeitwahrnehmung wird von Computersystemen radikal in Frage gestellt. Iterationen, Rekursionen und Schleifen sind Kontrollstrukturen in Programmroutinen, die einen bedingten und verzweigten Ablauf von Software erlauben.

Sie sind durch Differenzen und Wiederholungen geprägt und aktualisieren eine zyklische Zeitauffassung. Inwieweit diese dem menschlichen Zeitempfinden fremden Zeitlichkeiten in Computern vom Menschen nachvollzogen werden können, ist Gegenstand dieses Forschungsbereichs. An der Zeitform der digitalen Maschinen sind vor allem drei Momente modellbildend: Die Zeit ist diskret, die Latenzen zwischen den einzelnen Zeitmomenten sind extrem kurz und die Zeitmomente sind rekursiv aufeinander verwiesen. Diese Zeitform hat ihren Ursprung in der kybernetischen Modellbildung. Damit ist der Regelkreis angesprochen, der ein Steuersystem in seinem Operationsbereich hält, wie z.B. ein Thermostat die gewünschte Temperatur steuert. Dieses Denken findet seine historischen Vorläufer in der Prozessphilosophie von Whitehead und Hegel. An Hegels dialektischem Denken wird der Moment der Feedbackschleife ersichtlich, dass diese im Abgleich von Ist- und Sollwert einen Widerspruch auflöst. Der kritische Aspekt am Widerspruch ist, dass zwei antagonistische Positionen zu einer Revision auffordern, die nicht formal-logisch behoben werden kann, sondern erst in einem nächsten reflexiven zeitlichen Schritt, durch eine andere Position ersetzt wird. Whiteheads Zeitmodell ist ähnlich rekursiv, operiert aber auf einer ontologisch anderen Ebene. Whitehead entwickelte ein Prozessdenken, das die Prozesse atomisiert, in mikroskopisch kleine Ereignisse zerlegt, die der Mirkozeitlichkeit der computerbasierten System sehr nahe kommt. Auf einer Vielzahl an zeitlichen als auch räumlichen Skalen laufen dabei rekursiv verschachtelte Entwicklungen ab.

Texte

> Rekursive Reflexionen – Zur Protokybernetik bei Hegel und Whitehead.

> Hegels Idee des Lebens.

> Whiteheads wirkliche Einzelwesen.

> Rekursive Reflexionen – Zur Protokybernetik bei Hegel und Whitehead.

> Hegels Idee des Lebens.

> Whiteheads wirkliche Einzelwesen.

Originalshader (Quelle)

Feldtheorie – Die wohl gängigste Form der Beschreibung von komplexen Systemen ist seit geraumer Zeit das Netzwerk.

Dass Netzwerke, bedingt durch ihre Maschen, nicht alles fassen können, wird an der Latourschen Konzeption des Plasmas deutlich, das diese Leerstellen ausfüllt.

Plasma, als ionisierter Raumbereich, stellt Potentiale bereit, die durch oder von Medien erfasst werden.

Mobile Devices, Smartdust, Internet of Things, allgemein gesprochen eine omnipräsente Sensorik und Rechenkapazität stellt eine feldähnliche Infrastruktur dar. In Netzwerken lassen sich nur bestehende Akteure miteinander verknüpfen, die Konstruktion dieser ist nicht Teil der Netzwerktheorie. Die Berreiche ausserhalb und unterhalb der bestehenden Netzwerkinstanzen werden von Latour mit dem Begriff des Plasmas gefasst. Dieser unformatierten Hintergrund beinhaltet potentielle neue Verknüpfungsmöglichkeiten. Eine Annäherung mit dem physikalischen Begriff des Feldes soll diesen Urgrund von Beziehungen und Netzen aufdecken. Als theoretischer Erbe des Äthers enthebt das Feld den alles durchdringenden Urstoff mittels Feldgleichungen der Anschaulichkeit: Wellen propagieren und informieren den Raum. Der Status von Gegenständen verändert sich: Sie werden nicht mehr als im Raum situierte konstante Objekte angesehen sondern sind temporäre und lokale Auswirkungen des Feldes, eines informierten und strukturierten Raumes. An Mark B. N. Hansens atmosphärischen Medienbegriff angelehnt, wird hier versucht, kongrete medientechnische Operationen mittels des Feldkonzeptes zu fassen. Devices (PC, Handheld etc.) treten dabei nur mehr als Interfaces zu einer verteilten und Mess- und Rechenarchitektur auf. Durch die Vielzahl an verteilten medialen Operationen ist das Medium räumlich dispergiert, nicht mehr lokal beschränkt.

Mobile Devices, Smartdust, Internet of Things, allgemein gesprochen eine omnipräsente Sensorik und Rechenkapazität stellt eine feldähnliche Infrastruktur dar. In Netzwerken lassen sich nur bestehende Akteure miteinander verknüpfen, die Konstruktion dieser ist nicht Teil der Netzwerktheorie. Die Berreiche ausserhalb und unterhalb der bestehenden Netzwerkinstanzen werden von Latour mit dem Begriff des Plasmas gefasst. Dieser unformatierten Hintergrund beinhaltet potentielle neue Verknüpfungsmöglichkeiten. Eine Annäherung mit dem physikalischen Begriff des Feldes soll diesen Urgrund von Beziehungen und Netzen aufdecken. Als theoretischer Erbe des Äthers enthebt das Feld den alles durchdringenden Urstoff mittels Feldgleichungen der Anschaulichkeit: Wellen propagieren und informieren den Raum. Der Status von Gegenständen verändert sich: Sie werden nicht mehr als im Raum situierte konstante Objekte angesehen sondern sind temporäre und lokale Auswirkungen des Feldes, eines informierten und strukturierten Raumes. An Mark B. N. Hansens atmosphärischen Medienbegriff angelehnt, wird hier versucht, kongrete medientechnische Operationen mittels des Feldkonzeptes zu fassen. Devices (PC, Handheld etc.) treten dabei nur mehr als Interfaces zu einer verteilten und Mess- und Rechenarchitektur auf. Durch die Vielzahl an verteilten medialen Operationen ist das Medium räumlich dispergiert, nicht mehr lokal beschränkt.

Texte

> Der feldtheoretische Hintergrund von Kollektivierungsprozessen.

> Embedded Agents – Zur Wir-Intentionalität im Group Agency Konzept.

> Der feldtheoretische Hintergrund von Kollektivierungsprozessen.

> Embedded Agents – Zur Wir-Intentionalität im Group Agency Konzept.

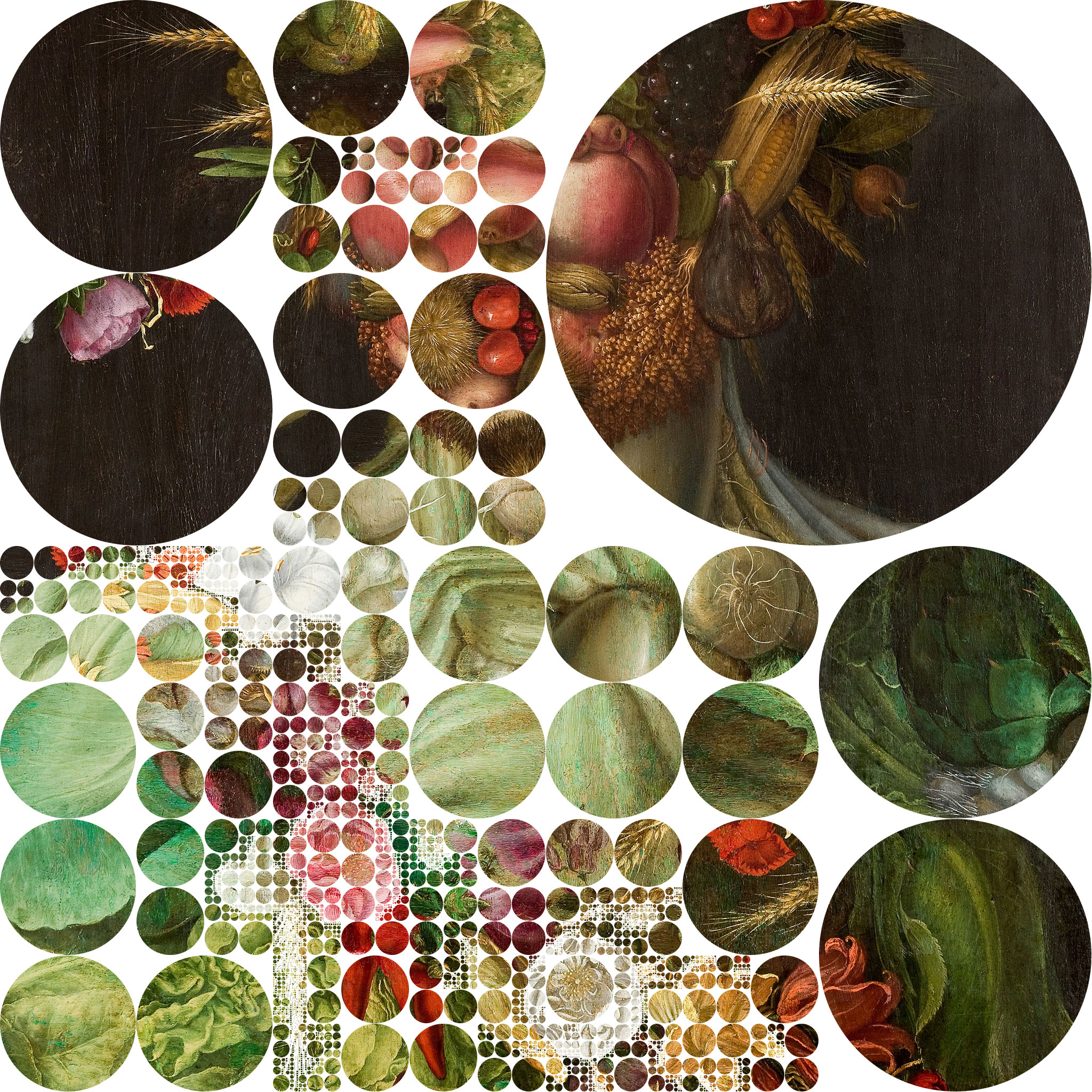

Originalbild: Vertumnus von Arcimboldo. Porträt von Kaiser Rudolf II (Quelle)

Unit Operations – Besteht die Welt aus Objekten, Systemen oder Prozessen?

Wenn es nach der Informatik gehen soll, werden Erstere präferiert. Objektorientierte Programmierung (OOP) ist das Paradigma der Informatik. Objekte entsprechen dabei Akteuren, die bestimmte Aufgaben übernehmen und über ihren Status berichten, wobei ihre interne Funktionalität von Aussen nicht einsehbar ist.

Die Idee des Blackboxing ist nicht neu, sie reicht Ideengeschlicht bis zu den Monaden Leibniz zurück, eine barocke überbordende Kosmologie. Die Philosophische Strömung der Objektorientierten Ontologie (OOO) weist klare Verwandschaftsbeziehungen zu dem Programmierparadigma auf. Ihr folgend besteht die Welt aus Objekten, die gleichberechtigt nebeneinander existieren, und miteiander agieren. Diese flachen Hierarchien nivelieren vorherige Differenzen: Menschen, Dinge und Begriffe exisiteren gleichberechtigt nebeneinander. Als Konsequenz daraus verschiebt sich die Aufmerksamkeit hin zur Metonymie, der Kontiguität, dem Verweilen auf der gleichen semantischen Ebene. Varianten und Modifikation sind von Interesse, was an dem Konzept der Klassen in OOP ersichtlich wird, aus denen Objekt instanziert werden, die untereinander variieren. Ian Bogost wendet unter dem Begriff der Unit Operations diese Konzeption auf Computerspiele an. Der Spieleravatar, die Gegenstände und selbst die Spielumgebung werden als Objekte angesehen, die bestimmte Funktionen inkorporieren. Durch Permutation dieser Objekte lassen sich eine Vielzahl an Spielabläufen generieren. Das Konzept der Objektorientierung lässt sich weiter denken. Auf die Objektorientierung mit ihren diskreten Identitäten und Differenzen folgt nach Alan Shapiro eine Software-Entwicklung der Ähnlichkeitsbeziehungen, die das von ihm sogenannte Konzept der Expanded Narration realisieren würde. Damit rückt dann die Trope Metapher in den Fokus.

Wenn es nach der Informatik gehen soll, werden Erstere präferiert. Objektorientierte Programmierung (OOP) ist das Paradigma der Informatik. Objekte entsprechen dabei Akteuren, die bestimmte Aufgaben übernehmen und über ihren Status berichten, wobei ihre interne Funktionalität von Aussen nicht einsehbar ist.

Die Idee des Blackboxing ist nicht neu, sie reicht Ideengeschlicht bis zu den Monaden Leibniz zurück, eine barocke überbordende Kosmologie. Die Philosophische Strömung der Objektorientierten Ontologie (OOO) weist klare Verwandschaftsbeziehungen zu dem Programmierparadigma auf. Ihr folgend besteht die Welt aus Objekten, die gleichberechtigt nebeneinander existieren, und miteiander agieren. Diese flachen Hierarchien nivelieren vorherige Differenzen: Menschen, Dinge und Begriffe exisiteren gleichberechtigt nebeneinander. Als Konsequenz daraus verschiebt sich die Aufmerksamkeit hin zur Metonymie, der Kontiguität, dem Verweilen auf der gleichen semantischen Ebene. Varianten und Modifikation sind von Interesse, was an dem Konzept der Klassen in OOP ersichtlich wird, aus denen Objekt instanziert werden, die untereinander variieren. Ian Bogost wendet unter dem Begriff der Unit Operations diese Konzeption auf Computerspiele an. Der Spieleravatar, die Gegenstände und selbst die Spielumgebung werden als Objekte angesehen, die bestimmte Funktionen inkorporieren. Durch Permutation dieser Objekte lassen sich eine Vielzahl an Spielabläufen generieren. Das Konzept der Objektorientierung lässt sich weiter denken. Auf die Objektorientierung mit ihren diskreten Identitäten und Differenzen folgt nach Alan Shapiro eine Software-Entwicklung der Ähnlichkeitsbeziehungen, die das von ihm sogenannte Konzept der Expanded Narration realisieren würde. Damit rückt dann die Trope Metapher in den Fokus.

Variante der Ulam Spirale: Sacks Spirale (Quelle)

Mediendramaturgie – Geschehnisse und Abläufe in fiktiven Realitäten sind durch eine bestimmte Wahrscheinlichkeit gekennzeichnet.

Traditionelle Erzählungen, Dramen und Filme folgen dabei etablierten Mustern. Eines der gängigsten ist die Aristotelische Konzeption eines Dramas, die einen abgeschlossenen Spannungsbogen beschreibt, sowie die wahrscheinlichen Übergänge zwischen den Handlungsphasen.

Bei computerbasierten Narrationen treten andere Übergänge, Verläufe und Muster auf. Die Grundlage all dieser unterschiedlichen Konzeptionen bilden numerische Archetypen rhythmisch er-/zählender Art. Mit der subjektiven und objektiven Wahrscheinlichkeit wird zwischen dem unterschieden was meistens passiert, und dem, was als generell akzeptiert, als plausibel angenommen wird. Genau diese Glaubwürdigkeit verschafft nach Aristoteles dem Plot eines Dramas eine höhere Wahrscheinlichkeit, vom Rezipienten als Imitation eines möglichen Handlungsablaufs wahrgenommen zu werden, und somit emotional bewegend auf diesen wirkt, da dies Geschehnis ihm selbst widerfahren könnte. Die Handlung im Drama soll von allgemeiner Art sein und eine bedeutungsvolle Verkettung der Ereignisse darstellen. Das Kriterium sinnvoll soll auch auf die Wendung im Drama zutreffen, die das Mitleiden und die spätere Reinigung von den beängstigenden Gefühle erzeugt. Sie soll nicht rein zufällig eintreten, sondern den Kriterien der Wahrscheinlichkeit unterliegen, im gleichen Moment soll sie aber überraschend sein, also konträr zu den Erwartungen der Rezipienten liegen. Das aristotelische Konzept kann als ein theatralischer Archetypus angesehen werden. Bei Archetypen handelt es sich um selbst wiederholende, dynamische Verhaltensmuster, die auf eine unanschauliche Grundform verweisen und in ihrer Ausprägung sich nicht unwesentliche unterscheiden. Der Zahlenarchetypus nimmt eine in zweierlei Sicht exponierte Stellung ein: Er kann als bewusstgewordener Aspekt für jegliche Form von rationaler Ordnung sowie rhythmischen Verhaltens angesehen werden und ist in seiner Serialität (Reihe der natürlichen Zahlen) als ab-/ erzählende Folge wesenskonstituiv für alle Archetypen, da diese sich in zeitlich geordneten Sequenzen manifestieren. Auf Grund seiner Abstraktheit, alle andern Archetypen sind in Analogiebildungen der Umwelt entlehnt und somit abbildender Art, ist er als Grundlage anzusehen, auf der heuristische sowie quantitative Beschreibungen aufbauen und kann somit eine Komplementarität von psychischem und ausserpsychischem Bereich erzeugen. Die Zahlen-/ Archetypen, die sich in der dramatischen Abfolge, in den besonderen mathematisch-physikalischen Kurven (Normalverteilung, Piosson-Verteilung etc.) sowie in den Funktionen zur mathematischen, rechnerbasierten Erzeugung von Zufall (deterministisches Chaos, Attraktoren) zeigen, können als Konstanten angesehen werden, die unerwartete Ereignisse sowie unvollständiges Wissen formal fassen.

Traditionelle Erzählungen, Dramen und Filme folgen dabei etablierten Mustern. Eines der gängigsten ist die Aristotelische Konzeption eines Dramas, die einen abgeschlossenen Spannungsbogen beschreibt, sowie die wahrscheinlichen Übergänge zwischen den Handlungsphasen.

Bei computerbasierten Narrationen treten andere Übergänge, Verläufe und Muster auf. Die Grundlage all dieser unterschiedlichen Konzeptionen bilden numerische Archetypen rhythmisch er-/zählender Art. Mit der subjektiven und objektiven Wahrscheinlichkeit wird zwischen dem unterschieden was meistens passiert, und dem, was als generell akzeptiert, als plausibel angenommen wird. Genau diese Glaubwürdigkeit verschafft nach Aristoteles dem Plot eines Dramas eine höhere Wahrscheinlichkeit, vom Rezipienten als Imitation eines möglichen Handlungsablaufs wahrgenommen zu werden, und somit emotional bewegend auf diesen wirkt, da dies Geschehnis ihm selbst widerfahren könnte. Die Handlung im Drama soll von allgemeiner Art sein und eine bedeutungsvolle Verkettung der Ereignisse darstellen. Das Kriterium sinnvoll soll auch auf die Wendung im Drama zutreffen, die das Mitleiden und die spätere Reinigung von den beängstigenden Gefühle erzeugt. Sie soll nicht rein zufällig eintreten, sondern den Kriterien der Wahrscheinlichkeit unterliegen, im gleichen Moment soll sie aber überraschend sein, also konträr zu den Erwartungen der Rezipienten liegen. Das aristotelische Konzept kann als ein theatralischer Archetypus angesehen werden. Bei Archetypen handelt es sich um selbst wiederholende, dynamische Verhaltensmuster, die auf eine unanschauliche Grundform verweisen und in ihrer Ausprägung sich nicht unwesentliche unterscheiden. Der Zahlenarchetypus nimmt eine in zweierlei Sicht exponierte Stellung ein: Er kann als bewusstgewordener Aspekt für jegliche Form von rationaler Ordnung sowie rhythmischen Verhaltens angesehen werden und ist in seiner Serialität (Reihe der natürlichen Zahlen) als ab-/ erzählende Folge wesenskonstituiv für alle Archetypen, da diese sich in zeitlich geordneten Sequenzen manifestieren. Auf Grund seiner Abstraktheit, alle andern Archetypen sind in Analogiebildungen der Umwelt entlehnt und somit abbildender Art, ist er als Grundlage anzusehen, auf der heuristische sowie quantitative Beschreibungen aufbauen und kann somit eine Komplementarität von psychischem und ausserpsychischem Bereich erzeugen. Die Zahlen-/ Archetypen, die sich in der dramatischen Abfolge, in den besonderen mathematisch-physikalischen Kurven (Normalverteilung, Piosson-Verteilung etc.) sowie in den Funktionen zur mathematischen, rechnerbasierten Erzeugung von Zufall (deterministisches Chaos, Attraktoren) zeigen, können als Konstanten angesehen werden, die unerwartete Ereignisse sowie unvollständiges Wissen formal fassen.

MEDIENMATERIALISMUS

Analog 2.0 – Wenn es in nicht zu ferner Zukunft zu einer Simulation eines menschlichen Gehirns kommen wird, wird diese voraussichtlich auf

Memristoren laufen.

In neuromorphen Schaltkreisen verbaut, entstehen Rechnerarchitekturen, die nur noch sehr wenig mit der aktuellen statischen Computerhardware gemeinsam haben.

Diese Prozessoren werden nicht mehr programmiert sondern optimieren sich analog zu evolutionären Prozessen. Die Hardware wird zur Software. Die Anzeichen für eine derartige Zukunft der Computer ist aktuelle an den Versprechen von Big Data, Intelligenten Assistenten (Siri, Cortana) sowie Autonomem Fahren abzulesen. Hinter diesen unterschiedlichen Vorhaben steht ein gemeinsames Anliegen, in grossen Datenmengen möglichst in Echtzeit Muster zu erkennen. Dabei steht weniger die Präzision der Datenanalyse im Vordergrund, als vielmehr unscharfe oder verrauschte Tendenzen und Formen zu erkennen. Es bedarf demnach nicht der digitalen Präzision. Diese Projekte legen nahe, auf analoge Rechenverfahren zurückzugreifen, die in Sachen Geschwindigkeit dem Digitalen weit vorraus sind. Als fundamentales viertes elektrisches Bauelement, neben Widerstand, Kondensator und Spule, unterscheidet sich der Memristor von diesen dadurch, dass er aufgrund der ihm eigenen Hysterese seinen vergangenen Zustand memoriert. Als variabler nicht-flüchtiger Widerstand wird er in Hardware-Neuronalen-Netzen als Speicher für die kontinuierlichen Verbindungsgewichte eingesetzt. Wenn er dagegen digital betrieben wird, legt der Memristor eine andere Logik nahe. An die Stelle der in CMOS Architekturen verwendeten Konjunktion tritt die Implikation, die im Sinne eines Konditionals sowie auch als temporale Verknüpfung angesehen werden kann, und damit die Günthersche Polykontexturale Logik verkörpert, eine temporale und kontextabhängige Logik. Nach Michael Conrad sind derartige Architekturen dringenst notwendig, um nicht weiterhin den ›Price of Programmability‹ zu bezahlen, auf Kosten von Programmierbarkeit polynominales Wachstum bei der Interaktion der Recheneinheiten einzubüßen. Vielmehr sollen alle Recheneinheiten untereinander verknüpfbar sein und sich gegenseitig evolutionär optimieren. Dieser Ansatz würde die Von-Neumann-Architektur verabschieden, mit ihrer Trennung von Speicher- und Recheneinheit und die damit einhergehende Flaschenhals-Problematik, die Latenz, die entsteht, wenn Daten aus dem Speicher in den Prozessor geladen werden. Es ist dann die Rede von Speicherrechner, Rechenelemente die sowohl als Speicher als auch als Rechenmodule genutzt werden und parallel operieren. Im Weiteren ist damit ein maschinelles Unbewusstes angesprochen, denn diese sub-symbolischen analogen Rechenprozesse verlaufen unterhalb der diskreten digitalen Symbolen, und es ist im nachinhein unmöglich, die Zustandsveränderungen zu rekonstruieren.

In neuromorphen Schaltkreisen verbaut, entstehen Rechnerarchitekturen, die nur noch sehr wenig mit der aktuellen statischen Computerhardware gemeinsam haben.

Diese Prozessoren werden nicht mehr programmiert sondern optimieren sich analog zu evolutionären Prozessen. Die Hardware wird zur Software. Die Anzeichen für eine derartige Zukunft der Computer ist aktuelle an den Versprechen von Big Data, Intelligenten Assistenten (Siri, Cortana) sowie Autonomem Fahren abzulesen. Hinter diesen unterschiedlichen Vorhaben steht ein gemeinsames Anliegen, in grossen Datenmengen möglichst in Echtzeit Muster zu erkennen. Dabei steht weniger die Präzision der Datenanalyse im Vordergrund, als vielmehr unscharfe oder verrauschte Tendenzen und Formen zu erkennen. Es bedarf demnach nicht der digitalen Präzision. Diese Projekte legen nahe, auf analoge Rechenverfahren zurückzugreifen, die in Sachen Geschwindigkeit dem Digitalen weit vorraus sind. Als fundamentales viertes elektrisches Bauelement, neben Widerstand, Kondensator und Spule, unterscheidet sich der Memristor von diesen dadurch, dass er aufgrund der ihm eigenen Hysterese seinen vergangenen Zustand memoriert. Als variabler nicht-flüchtiger Widerstand wird er in Hardware-Neuronalen-Netzen als Speicher für die kontinuierlichen Verbindungsgewichte eingesetzt. Wenn er dagegen digital betrieben wird, legt der Memristor eine andere Logik nahe. An die Stelle der in CMOS Architekturen verwendeten Konjunktion tritt die Implikation, die im Sinne eines Konditionals sowie auch als temporale Verknüpfung angesehen werden kann, und damit die Günthersche Polykontexturale Logik verkörpert, eine temporale und kontextabhängige Logik. Nach Michael Conrad sind derartige Architekturen dringenst notwendig, um nicht weiterhin den ›Price of Programmability‹ zu bezahlen, auf Kosten von Programmierbarkeit polynominales Wachstum bei der Interaktion der Recheneinheiten einzubüßen. Vielmehr sollen alle Recheneinheiten untereinander verknüpfbar sein und sich gegenseitig evolutionär optimieren. Dieser Ansatz würde die Von-Neumann-Architektur verabschieden, mit ihrer Trennung von Speicher- und Recheneinheit und die damit einhergehende Flaschenhals-Problematik, die Latenz, die entsteht, wenn Daten aus dem Speicher in den Prozessor geladen werden. Es ist dann die Rede von Speicherrechner, Rechenelemente die sowohl als Speicher als auch als Rechenmodule genutzt werden und parallel operieren. Im Weiteren ist damit ein maschinelles Unbewusstes angesprochen, denn diese sub-symbolischen analogen Rechenprozesse verlaufen unterhalb der diskreten digitalen Symbolen, und es ist im nachinhein unmöglich, die Zustandsveränderungen zu rekonstruieren.

Niveau-Schemas eines Mems (Förster: Das Gedächtnis – Ein quantenphysikalische Untersuchung)

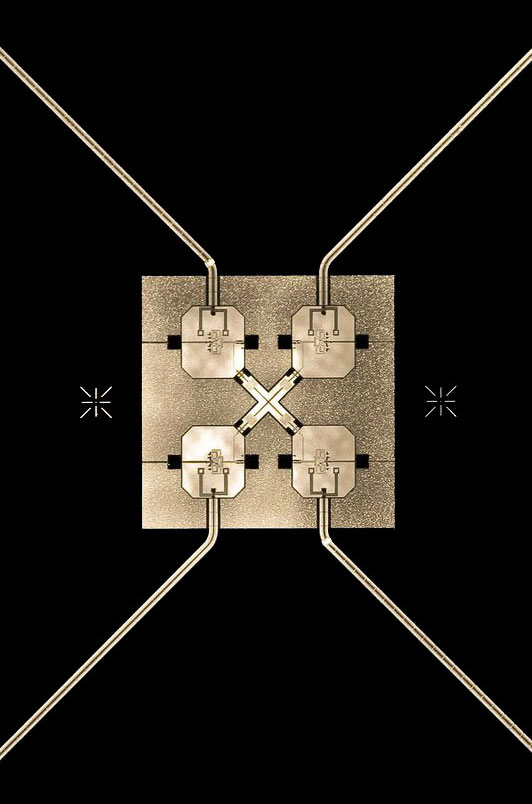

Quibit Chip (Quelle)

Quantencomputer – Parallele Universen, spukhafte Fernwirkung und Teleportation sind Ideen, die scheinbar mit der Quantenphysik Realität werden.

Grundlegend dabei ist das Phänomen der Quantenverschränkung. Quantenobjekte, die einmal verschränkt wurden, bleiben weiterhin aufeinander bezogen, selbst nach räumlicher Trennung.

Es treten Ereignisse auf, die mit dem Alltagsbewusstsein nicht verstehbar sind: Retrokausalität, Nichtlokalität und Superpositionen, mit denen aber gerechnet werden kann.

Das andersartige bei diesen Rechenvorgänge ist, dass viele Berechnungen simultan ausgeführt werden, anders gesagt, der Quantenrechner befindet sich in einem überlagerten Zustand

und erst bei einer Messung kollabiert der Zustand zu einem eindeutigen Ergebnis. Dass dieses Ergebnis sich im nachhinein ändern kann und dass der Quantencomputer sich nicht nur

an einem exakten Ort befinden muss, sondern an mehreren gleichzeitig existieren kann, hat nichts mehr mit der gängigen Auffassung von kongret existierenden Dingen zu tun.

Weiter gedacht erzwingen diese im Moment noch experimentellen Rechenkonzepte Folgen in anderen Bereichen, wie der Neurobiologie mit ihren Implikationen für das menschliche Bewusstsein.

Alle Rechnerkonzepte hegen eine innige Verwandschaftsbeziehung mit den Konzepten der Funktionsweise des menschlichen Gehirns.

Wenn Gedanken Quantenphänomenen gleichen, sind sie dann überlagerte mehrwertige Gebilde die willentlich auf einen Wert reduziert werden, von einem diffusen unbewussten in einen

kongreten bewussten Gedanken überführt werden? Wenn Gedanken korrelierte Zustände sind, sind sie dann im ganzen Gehirn global anwesend, oder gar auf mehrere Gehirne verteilt, können

mehrere Menschen den gleichen Gedanken simultan denken? Liegen Stimmungen/Emotionen in der Luft, oder sind das Wirkungen des Quantenfeldes?

Text und Video

> Das Feld als nicht-lokaler Speicher.

> 10.000C. Zur Temporalität der Quantenverschränkung.

Arbeitstagung des Lehrstuhls Medientheorien (Humboldt-Universität zu Berlin) in Kooperation mit dem Institut für Experimentelle Design- und Medienkulturen (Hochschule für Gestaltung und Kunst, Basel). »Zeitigungen von Medien. Epistemologische, gestalterische und experimentelle Alternativen zur (bisherigen) Mediengeschichtsschreibung.«

> Das Feld als nicht-lokaler Speicher.

> 10.000C. Zur Temporalität der Quantenverschränkung.

Arbeitstagung des Lehrstuhls Medientheorien (Humboldt-Universität zu Berlin) in Kooperation mit dem Institut für Experimentelle Design- und Medienkulturen (Hochschule für Gestaltung und Kunst, Basel). »Zeitigungen von Medien. Epistemologische, gestalterische und experimentelle Alternativen zur (bisherigen) Mediengeschichtsschreibung.«

Schaltplan einer nicht-trivialen Maschine (von Foerster, Wissen und Gewissen)

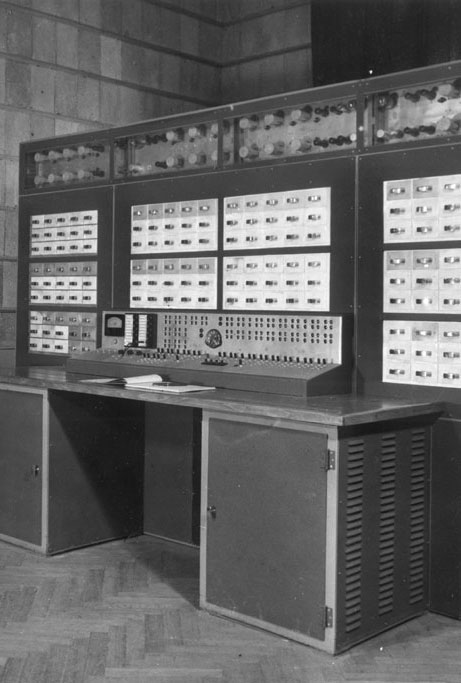

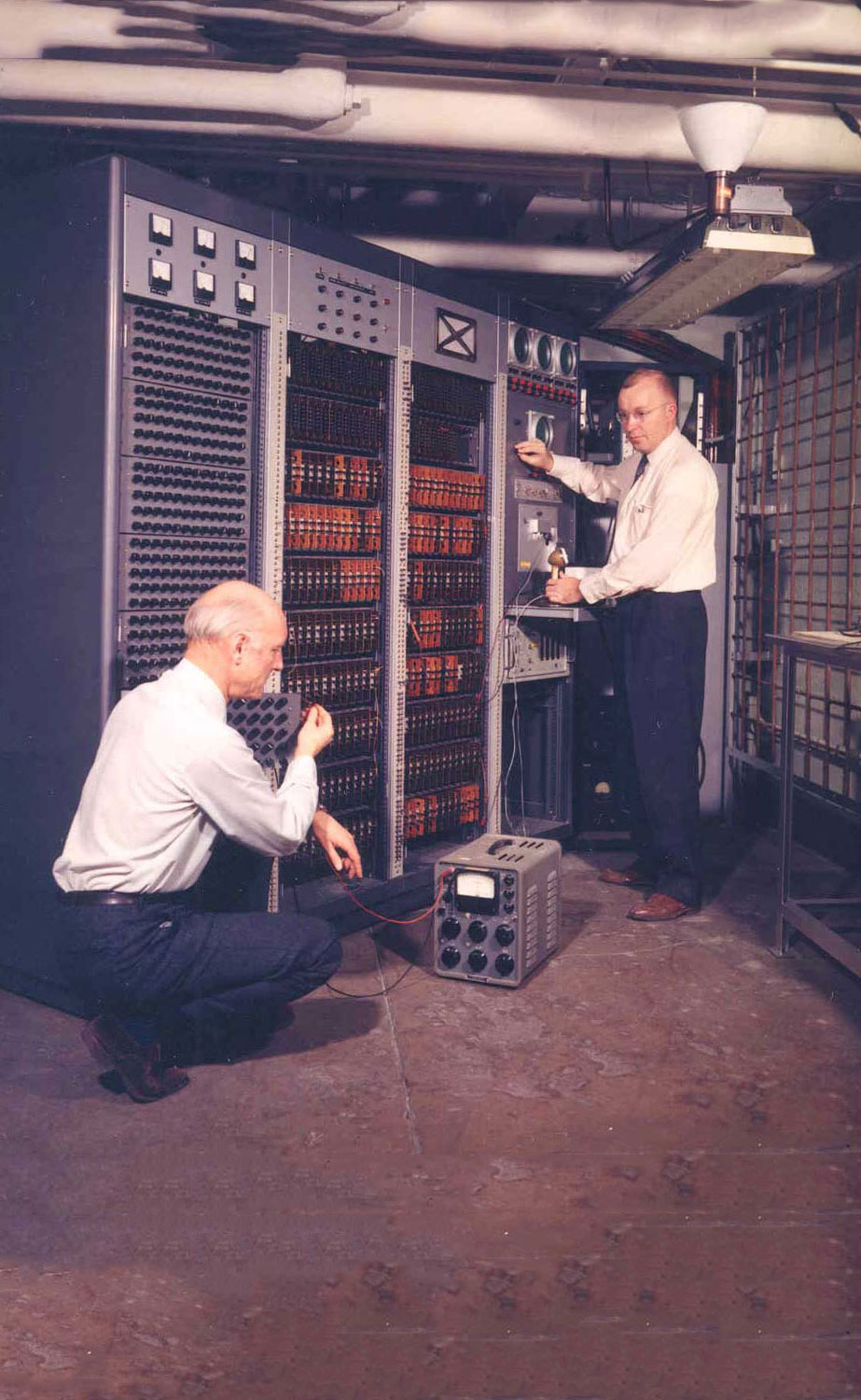

Von Foerster und Babcock demonstrieren den Dynamic Signal Analyzer. (Quelle)

nicht-triviale Maschinen – Seit dem Aufkommen der Kybernetik in den 1940er Jahren wird nicht mehr zwischen Lebewesen und Maschinen unterschieden,

wenn es darum geht, informationsverabeitende Prozesse in diesen zu beschreiben.

Lebewesen/Maschinen werden als organisatorisch geschlossene Systeme angesehen, die mit ihrer Umwelt

nicht kommunizieren, sondern interne Repräsentationen der Außenwelt aufgrund von internen Rechenprozessen bilden.

Bei dem zirkulärer Fluss von Signalen in kybernetischen Systemen, dem Abgleich ihrer ›Sinnesdaten‹ mit der Lage ihrer ›Gliedmaßen‹, handelt es sich um Prozesse, in denen sich ein Zustand

selbst reproduziert, modern gesprochen handelt es sich um Rekursivität.

Idealerweise strebt das System einen Gleichgewichtszustand an (Homöostase). Aufgrund von Umwelteinflüssen kann das System gezwungen werden, seinen angestrebten Zustand abzuändern, was den

Übergang von einer trivialen zu einer nicht-trivialen Maschine markiert. Dabei handelt es sich nicht um ein kausales Reiz-Reaktions-Schema. Basierend auf seiner vergangenen Erfahrungen

plus eines Zufallwertes wird das System einen neuen Zustand auswählen und versuchen diesen wiederum zu halten.

Die nicht-trivialen Maschinen bilden die Grundlage der neuronalen Netze, das Paradigma von intelligenten sich selbst optimierenden Systemen.

SETUN – Sind alle Aussagen auf binäre Entscheidungen zu reduzieren, also auf Ja oder Nein, wie es in digitalen Computer stattfindet?

Wie sieht es mit zukünftigen Ereignissen aus? Ob morgen eine Seeschlacht stattfindet oder nicht, ist heute nicht entscheidbar. Logiker stellen sich den Wert von unentscheidbare Aussagen als Grenze zwischen Ja und Nein vor, als Wert, der weder zu Ja noch zu Nein gehört. Vielmehr stellt sie einen dritten Wert dar, der mit unentscheidbar oder unendlich bestimmt ist. Derartige Werte sind aber in digitalen, binären Rechnern nicht abbildbar. Als der einzige je gebaute dreiwertige Computer gilt der in den 1960er Jahren realisierte sowjetische Ternärrechner SETUN. Er arbeitete mit einer balancierten ternären Artithmetik, mit den Werten -1, 0, 1. Dabei wurden ternäre Schaltelemente (Flip-Flap-Flop) als auch ternäre Rechenoperationen (Tritweise Operatoren) entwickelt. Dass der Computer nach dem gleichnamigen Fluss in Moskau benannt ist, kann als eine Metapher der Operationsweise der Maschine angesehen werden. Durch die Realisierung der alternierenden tritweisen Operationen der Recheneineinheit mittels Zweiphasenwechselstrom drängt sich das Bild von interferierenden Wellenbewegungen des Wassers auf. Um eine weiteres Gleichnis herzustellen, wird auf eine bekannte Metapher Lacans zurückgegriffen. Die kybernetische Tür versinnbildlicht bei Lacan die binäre Logik: Die Tür kann entweder offen oder geschlossen sein, wie der elektrische Schaltkreis in einem Computer. Unter der ternären Logik kann die Türe in beide Richtungen geöffnet werden, sie eher einer Schwingtür gleicht, was zur Folge hat, dass sie in beide Durchgangsrichtungen ohne betätigen eines Schließmechanismus geöffnet werden kann, sowie ein Nachschwingen bzw. eine Resonanz aufweist. Diese Tür ist wenn dann nur im Grenzbereich geschlossen oder offen.

Wie sieht es mit zukünftigen Ereignissen aus? Ob morgen eine Seeschlacht stattfindet oder nicht, ist heute nicht entscheidbar. Logiker stellen sich den Wert von unentscheidbare Aussagen als Grenze zwischen Ja und Nein vor, als Wert, der weder zu Ja noch zu Nein gehört. Vielmehr stellt sie einen dritten Wert dar, der mit unentscheidbar oder unendlich bestimmt ist. Derartige Werte sind aber in digitalen, binären Rechnern nicht abbildbar. Als der einzige je gebaute dreiwertige Computer gilt der in den 1960er Jahren realisierte sowjetische Ternärrechner SETUN. Er arbeitete mit einer balancierten ternären Artithmetik, mit den Werten -1, 0, 1. Dabei wurden ternäre Schaltelemente (Flip-Flap-Flop) als auch ternäre Rechenoperationen (Tritweise Operatoren) entwickelt. Dass der Computer nach dem gleichnamigen Fluss in Moskau benannt ist, kann als eine Metapher der Operationsweise der Maschine angesehen werden. Durch die Realisierung der alternierenden tritweisen Operationen der Recheneineinheit mittels Zweiphasenwechselstrom drängt sich das Bild von interferierenden Wellenbewegungen des Wassers auf. Um eine weiteres Gleichnis herzustellen, wird auf eine bekannte Metapher Lacans zurückgegriffen. Die kybernetische Tür versinnbildlicht bei Lacan die binäre Logik: Die Tür kann entweder offen oder geschlossen sein, wie der elektrische Schaltkreis in einem Computer. Unter der ternären Logik kann die Türe in beide Richtungen geöffnet werden, sie eher einer Schwingtür gleicht, was zur Folge hat, dass sie in beide Durchgangsrichtungen ohne betätigen eines Schließmechanismus geöffnet werden kann, sowie ein Nachschwingen bzw. eine Resonanz aufweist. Diese Tür ist wenn dann nur im Grenzbereich geschlossen oder offen.